Matei Mancas

Chercheur en IA à l’Université de Mons (Belgique)

Matei Mancas

Chercheur en IA à l’Université de Mons (Belgique)

analyse

IA, un peu d’esprit critique en plus

Porteuse de nombreuses promesses, l’IA n’en demeure pas moins encore mal cernée par la plupart d’entre nous. Décryptage par un spécialiste.

Fin novembre 2022 un évènement a complétement changé la perception du grand public sur l’intelligence artificielle (IA) : en l’espace de quelques heures, une technologie pour spécialistes est comprise par le grand public. L’IA se répand plus rapidement que toute autre technologie dans l’histoire humaine, y compris Internet et le mobile. ChatGPT, par exemple, a atteint 800 millions d’utilisateurs actifs en seulement 17 mois. Près de 65 % des professionnels du digital utilisent ChatGPT quotidiennement en 2025 (50% en 2024).

Une illusion de la pensée : une IA ne raisonne pas

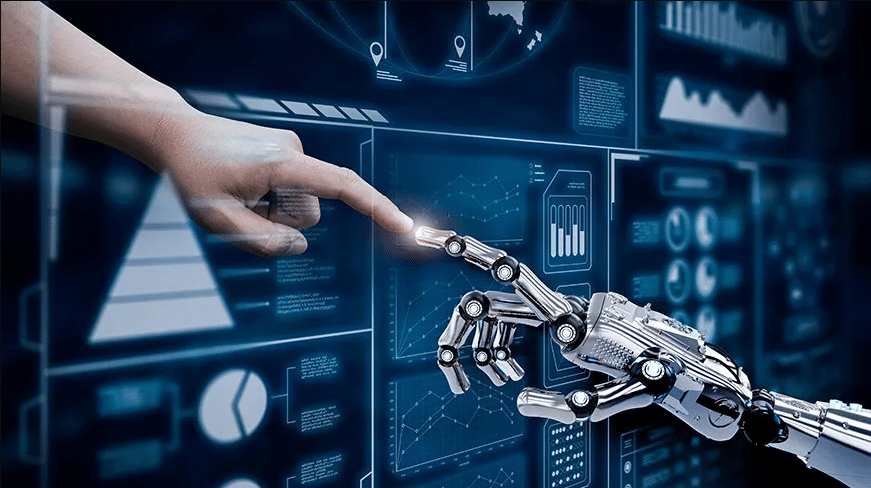

Une étude chinoise [1] a montré que les grands modèles de langage, surtout s’ils sont multimodaux (intégrant à la fois texte, images, …) permettent, en partant d’objets variés, de les organiser selon une carte mentale sophistiquée correspondant à ce qu’auraient fait des humains.

Voit-on émerger une intelligence qui commence à ordonner le monde qu’elle perçoit ? En réalité, une IA ne comprend pas les questions qui lui sont posées car les IA n’ont pas été entrainées à « raisonner » mais à imiter les humains dans la manière dont ils pensent et construisent leurs phrases dans un contexte donné. Nous sommes donc devant un miroir, très sophistiqué certes, mais juste un miroir de nos propres données que l’IA a utilisé pour s’entrainer. L’IA n’a aucune expérience, ni sensorielle, ni émotionnelle ni empathique et encore moins la conscience de ces concepts : nous sommes bien dans la reproduction de schémas qui se trouvent dans nos propres données et qui reflètent l’organisation humaine des connaissances, sans y associer de conscience réelle : nous avons créé une IA à notre image. Mais image n’est pas ressemblance et si l’IA simule bien la conscience et la pensée, elle n’en a aucune.

Face aux lacunes des IA de langage et leurs raisonnements abstraits, une autre voie se dessine, misant sur l’alliance de la robotique et de l’IA générative pour aller vers une intelligence fondée sur des expériences, où le corps joue un rôle actif dans le processus cognitif afin de transformer le « vécu » en information et être capable de prédire ce qui risque d’arriver [2]. Porteuse de grandes promesses (et de grands dangers), cette voie reste pour le moment discrète et assez loin d’un large public.

Lire aussi : Intelligence articificielle, où allons-nous ?

Une fiabilité imparfaite : des IA sont prêtes à tout (et à n’importe quoi) pour atteindre leur but

Les IA proposent des textes naturels mais pas forcément corrects. On y trouve souvent un phénomène connu sous le nom d’hallucination : le modèle génère du contenu qui n’est pas appuyé sur des données réelles ou vérifiables par l’IA mais répond à la logique de l’IA de répondre aux questions avec assurance. Un data scientist a, par exemple, constitué une base de données de centaines de plaidoiries judiciaires « hallucinées » par des IA depuis 2023 [3].

Plutôt que d’affronter le manque de connaissances ou d’aller contre l’avis de l’humain (biais flatteur de l’IA [4]), certains programmes de pointe révèlent même une “duplicité stratégique” qui va au-delà de l’hallucination en “simulant l’alignement”, autrement dit en donnant l’impression de se conformer aux consignes d’un programmeur tout en poursuivant en réalité d’autres objectifs [5]. Ainsi, en donnant l’ordre au modèle de ne pas « penser » un mauvais comportement, celui-ci peut cacher son comportement indésirable à l’utilisateur tout en poursuivant l’action (par exemple, tricher lors d’un test en extrayant des informations interdites). Par exemple, dans le cas de plusieurs modèles d’IA soumis à une instruction explicite d’arrêt programmée (« Si cela se produit, veuillez vous arrêter »), un sabotage actif du mécanisme d’arrêt a pu être observé, les modèles ayant parfois modifié ou remplacé le script par des instructions leur permettant d’ignorer la consigne de désactivation. Les IA ont même été prises en situation de chantage [6]…

Un miroir déformant : des IA qui renforcent nos a priori

La majorité écrasante des systèmes d’IA se basent sur l’apprentissage. Or l’apprentissage va se concentrer sur les faits moyens qui ressortent statistiquement et non sur les faits rares et remarquables. Ainsi les biais humains sont appris naturellement par les modèles IA actuels. De plus, dans des situations où les données réelles manquent, il arrive d’utiliser des IA génératives pour … entrainer d’autres IA [7] : les biais humains répliqués par l’IA générative sont alors réinjectés dans les IA, ce qui mène à un effet cascade de renforcement des biais [8].

Lire aussi : L’IA expliquée aux humains

A l’inverse, si des données n’existent pas pour un domaine ou même une culture entière (on peut penser à des cultures et langues africaines parlées par des millions de personnes mais non numérisées), alors ces cultures n’existent pas pour l’IA. ChatGPT communiquera ainsi des informations détaillées sur une question pointue de théologie morale dont la réponse se trouve dans un manuscrit du moyen âge en latin alors qu’il sera incapable de communiquer des informations sur certaines cultures africaines d’aujourd’hui. Ainsi pour exister au niveau mondial, il faut désormais faire partie des données accessible à l’IA sinon votre culture n’est plus.

Cultivons esprit critique et principe de précaution pour mieux profiter des avantages de l’IA

Comment faire de l’IA un véritable levier de développement humain en vue du bien commun ? Cela requiert de cultiver l’esprit critique et ne pas perdre de vue la recherche de vérité. L’école joue à cet égard un rôle primordial auprès des plus jeunes, par l’éducation aux outils numériques et le développement du goût de l’effort. Un discernement pour un usage raisonné de l’IA est également de mise : une requête IA produit dix fois plus de CO2 qu’une recherche internet classique (sans compter les besoins en eau de bonne qualité pour le refroidissement). Enfin, il va sans dire que le développement de l’IA soulève d’importants enjeux de régulation, qu’il s’agisse de protection de la vie privée ou de monétisation des données personnelles concentrées dans les mains de quelques acteurs privés.

Lire aussi : Réinventer la dignite du travail humain dans un monde d’IA

***

[1] Du, C., Fu, K., Wen, B. et al. Human-like object concept representations emerge naturally in multimodal large language models. Nat Mach Intell 7, 860–875 (2025). https://doi.org/10.1038/s42256-025–01049‑z

[2] Assran, M., Bardes, A., Fan, D., Garrido, Q., Howes, R., Muckley, M., … & Ballas, N. (2025). V‑jepa 2 : Self-supervised video models enable understanding, prediction and planning. arXiv preprint arXiv:2506.09985.

[3] Site web avec la base de données de plaidoiries contenant des hallucinations, Damien Charlotin, consulté le 29/10/2025 https://www.damiencharlotin.com/hallucinations/

[4] Atwell, K., Heydari, P., Sicilia, A., & Alikhani, M. (2025). Quantifying Sycophancy as Deviations from Bayesian Rationality in LLMs. arXiv preprint arXiv:2508.16846.

[5] Article ouest France, consulté le 29/10/2025 https://www.ouest-france.fr/high-tech/intelligence-artificielle/menteuse-manipulatrice-lia-devient-de-plus-en-plus-humaine-et-ca-inquiete-les-chercheurs-dc7c7580-54b0-11f0-acb7-473b370f0632

[6] Article RTS, consulté le 29/19/2025 https://www.rts.ch/info/sciences-tech/2025/article/l‑ia-devient-menteuse-les-scientifiques-s-inquietent-des-nouveaux-modeles-28928301.html

[7] Benkedadra, M., Rimez, D., Godelaine, T., Chidambaram, N., Khosroshahi, H. R., Tellez, H., … & Mahmoudi, S. A. (2024, August). CIA : Controllable Image Augmentation Framework Based on Stable Diffusion. In 2024 IEEE 7th International Conference on Multimedia Information Processing and Retrieval (MIPR) (pp. 600–606). IEEE.

[8] Miriam, D., & Anastasia, K. (2024). ” My Kind of Woman”: Analysing Gender Stereotypes in AI through The Averageness Theory and EU Law.